#45 - Fichier des décès de l'INSEE depuis 1970 et deces.matchid

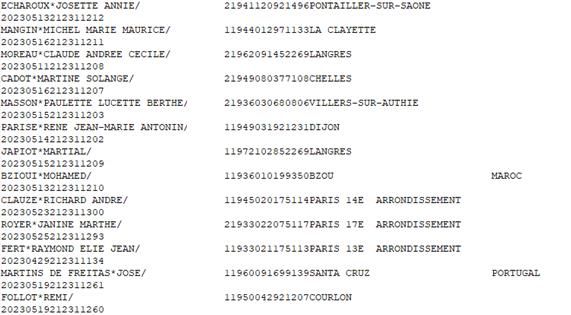

Depuis la fin de l'année 2019 (et à la suite d’un avis de la CADA), l’INSEE publie chaque mois en open data le fichier des personnes décédées depuis 1970 (voir sur data.gouv). Les données mises à disposition sont de merveilleux fichier TXT contenant les noms (de naissance), prénoms, date et lieu de naissance, date et lieu de décès et numéro d’acte.

Depuis la fin de l'année 2019 (et à la suite d’un avis de la CADA), l’INSEE publie chaque mois en open data le fichier des personnes décédées depuis 1970 (voir sur data.gouv). Les données mises à disposition sont de merveilleux fichier TXT contenant les noms (de naissance), prénoms, date et lieu de naissance, date et lieu de décès et numéro d’acte.

Attention, il y a des lacunes, notamment entre les années 1970 et 1980 (voir aussi la FAQ de deces.matchid).

Qui dit open data, dit plein de réutilisations possibles, aussi bien pour des applications de recherche et d'accès aux données que pour des visualisations graphiques. Un certain nombre de ces réutilisations sont signalées sur data.gouv.fr. Les données sont par ailleurs intégrées aux sites Internet de généalogie en ligne comme Geneanet ou Filae.

Parmi les applications facilitant l'interrogation des données, j'aime tout particulièrement deces.matchid, lancée en 2020 par Fabien Antoine, Martin Gross et Cristian Perez Brokate à la suite d'un projet comme entrepreneurs d’intérêt général au ministère de l’Intérieur. Le projet, aujourd’hui disponible en open source, est développé et maintenu de manière bénévole.

Cet outil est assez génial et incontournable quand on veut publier des données nominatives récentes en ligne (au hasard : des inventaires d'archives respectueux du RGPD, en vérifiant que les gens sont "assez morts"), enrichir ses propres données (avec des prénoms et des dates et lieux d'existence précis), ou encore pour enrichir ses recherches généalogiques personnelles sur les 20e et 21e siècles.